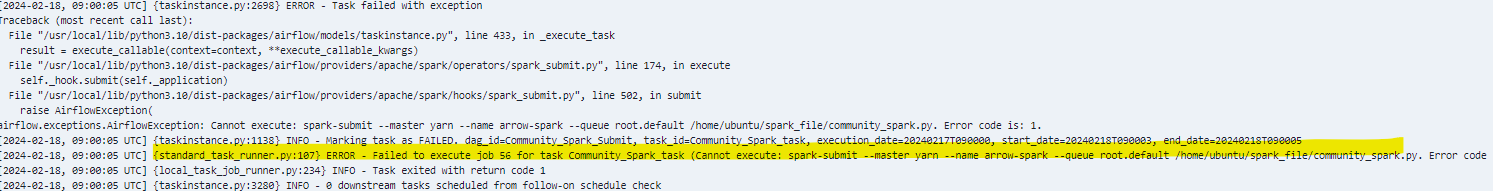

Airflow의 스케줄링을 이용해서 Spark를 submit하려고했지만 위와 같은 에러가 발생하였습니다.

에러의 원인은 spark의 default connection의 host가 yarn으로 설정되어 있어 발생하였습니다.

분산모드가 아닌 로컬 모드에서 테스트로 이루어지는 상황에서

host가 yarn으로 설정되어 있기 때문에 이러한 에러가 발생하였습니다.

spark를 submit할때는 spark conection이 올바르게 설정되어 있어야합니다.

만약 master를 yarn으로 실행시키실 경우(분산모드) host를 yarn으로 변경해주시고,

local에서 실행하실 경우 (standalone모드) host를 local로 변경해주세요.

'데이터 엔지니어 > Airflow' 카테고리의 다른 글

| [Airflow] Selenium 실행 시 발생 에러 ('NoneType' object has no attribute 'split'; 2256) (0) | 2024.01.25 |

|---|